什么是NPU?

发布时间:2025-08-28 17:27:53

点击量:100

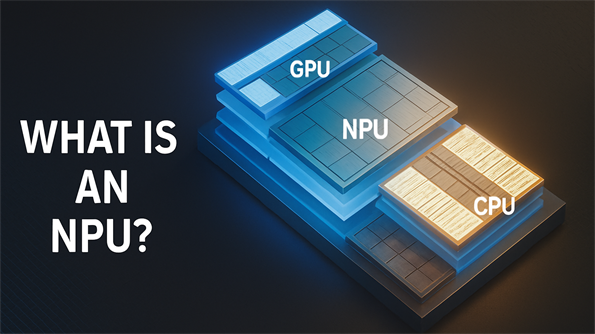

人工智能正在迅速重塑各行各业,从支持生产线上的实时缺陷检测,到赋能更智能的移动应用。多年来,CPU 和 GPU 一直是 AI 计算的支柱,而神经处理单元 (NPU) 的兴起标志着 AI 工作负载执行方式(尤其是在边缘计算)的重大转变。

那么,NPU 究竟是什么?它与其他处理器相比有何不同?以及为什么它会成为现代计算中如此重要的组成部分?

神经处理单元 (NPU)是一种专用微处理器,专为加速机器学习和深度学习中使用的神经网络计算而设计。与专为顺序任务构建的通用 CPU 或擅长大规模并行运算(例如训练模型)的 GPU 不同,NPU 几乎完全专注于推理——即已训练模型实时进行预测的阶段。

其架构根据神经网络的数据流量身定制,优先执行矩阵乘法和矢量处理等运算。最终,NPU 能够高效处理海量数据,同时功耗极低。这使得 NPU 在能效和速度至关重要的环境中尤为重要,例如移动设备、嵌入式物联网系统或工业自动化设备。

本质上,NPU 是一个轻量级的专用 AI 引擎,可以在本地运行复杂任务,而无需持续依赖云资源。

NPU 的重要性源于其能够兼顾性能、效率和低延迟,而传统处理器往往无法做到这一点。CPU 灵活多用,但并未针对 AI 的繁重并行计算进行优化。GPU 拥有出色的吞吐量,对于训练大型模型至关重要,但其高功耗限制了其在紧凑型或移动系统中的实用性。NPU

弥补了这一差距。它们能够提供实时应用所需的效率,例如面部识别、自然语言处理、预测性维护和工业机器视觉。通过将 AI 工作负载从 CPU 和 GPU 上卸载,NPU 可以降低能耗、提高处理速度,并让主处理器专注于其他任务。这种分工在尺寸、散热限制和功耗预算受限的边缘部署中尤为重要。

技术提供商已经开始将 NPU 集成到主流硬件中。例如,英特尔推出了其首款采用Meteor Lake架构的内置 NPU,并将其命名为英特尔® AI Boost。与前几代产品相比,这项创新将能效提高了数倍,使得稳定扩散、聊天机器人推理和智能系统监控等 AI 功能可直接在个人计算机和边缘设备上实现。

另一个主要参与者是Hailo,其专用AI 加速器芯片比英特尔的集成 NPU 提供了更高的处理能力。Hailo 的解决方案通常用于要求更高的应用,例如智能驾驶系统或先进的工业自动化,这些应用中的工作负载更重,需要更强大的性能,同时仍要保持效率。

总之,这些例子突显了 NPU 不再是小众组件,而越来越成为消费和工业硬件的标准配置。

NPU 最适合用于 AI 必须在本地可靠运行且能耗极低的场景。它们在处理基于视觉的任务(例如物体检测、图像分类和生产线上的自动分拣)方面尤其有效。它们还能支持智能手机中的智能功能,例如实时翻译和语音助手,同时避免持续的云通信,从而确保低延迟。

CPU、GPU 和 NPU 之间的选择取决于工作负载的性质。对于训练大规模 AI 模型,GPU 和 TPU 仍然是最佳选择。对于包含较轻量级 AI 任务的多功能计算,CPU 仍然具有价值。然而,对于高效且反复地运行预训练模型,NPU 是无与伦比的。它们提供了最节能且经济的方式来处理推理工作负载,尤其是在大规模和边缘环境中。

随着人工智能持续从以云为中心的处理向边缘部署迁移,NPU 势必将成为未来计算平台不可或缺的一部分。它们在功耗和性能之间实现了完美平衡,使智能能够直接嵌入到设备中,而无需承担持续云交互带来的成本和延迟。

从智能手机到医疗计算机,从工厂自动化到智慧城市,NPU 正悄然成为实现本地化人工智能的引擎。在英特尔和 Hailo 等公司引领创新的背景下,NPU 的普及预示着更广泛的行业趋势:高效、可扩展的人工智能将越来越多地在设备上运行,让我们更接近真正智能的边缘生态系统。

那么,NPU 究竟是什么?它与其他处理器相比有何不同?以及为什么它会成为现代计算中如此重要的组成部分?

什么是NPU?

神经处理单元 (NPU)是一种专用微处理器,专为加速机器学习和深度学习中使用的神经网络计算而设计。与专为顺序任务构建的通用 CPU 或擅长大规模并行运算(例如训练模型)的 GPU 不同,NPU 几乎完全专注于推理——即已训练模型实时进行预测的阶段。

其架构根据神经网络的数据流量身定制,优先执行矩阵乘法和矢量处理等运算。最终,NPU 能够高效处理海量数据,同时功耗极低。这使得 NPU 在能效和速度至关重要的环境中尤为重要,例如移动设备、嵌入式物联网系统或工业自动化设备。

本质上,NPU 是一个轻量级的专用 AI 引擎,可以在本地运行复杂任务,而无需持续依赖云资源。

为什么NPU如此重要

NPU 的重要性源于其能够兼顾性能、效率和低延迟,而传统处理器往往无法做到这一点。CPU 灵活多用,但并未针对 AI 的繁重并行计算进行优化。GPU 拥有出色的吞吐量,对于训练大型模型至关重要,但其高功耗限制了其在紧凑型或移动系统中的实用性。NPU

弥补了这一差距。它们能够提供实时应用所需的效率,例如面部识别、自然语言处理、预测性维护和工业机器视觉。通过将 AI 工作负载从 CPU 和 GPU 上卸载,NPU 可以降低能耗、提高处理速度,并让主处理器专注于其他任务。这种分工在尺寸、散热限制和功耗预算受限的边缘部署中尤为重要。

现代计算中的 NPU

技术提供商已经开始将 NPU 集成到主流硬件中。例如,英特尔推出了其首款采用Meteor Lake架构的内置 NPU,并将其命名为英特尔® AI Boost。与前几代产品相比,这项创新将能效提高了数倍,使得稳定扩散、聊天机器人推理和智能系统监控等 AI 功能可直接在个人计算机和边缘设备上实现。

另一个主要参与者是Hailo,其专用AI 加速器芯片比英特尔的集成 NPU 提供了更高的处理能力。Hailo 的解决方案通常用于要求更高的应用,例如智能驾驶系统或先进的工业自动化,这些应用中的工作负载更重,需要更强大的性能,同时仍要保持效率。

总之,这些例子突显了 NPU 不再是小众组件,而越来越成为消费和工业硬件的标准配置。

NPU 的优势

NPU 最适合用于 AI 必须在本地可靠运行且能耗极低的场景。它们在处理基于视觉的任务(例如物体检测、图像分类和生产线上的自动分拣)方面尤其有效。它们还能支持智能手机中的智能功能,例如实时翻译和语音助手,同时避免持续的云通信,从而确保低延迟。

在工业环境中,NPU 使机器视觉系统能够即时检测装配线上的缺陷,或使监控系统能够实时分析视频流。医疗保健设备也受益于其效率,支持可穿戴监视器和便携式诊断工具。自动驾驶汽车也依赖 NPU 快速处理传感器数据,以实现导航和决策。

NPU 与 CPU、GPU 和 TPU 的主要区别

| 加速器 | 最适合 | 优势 | 理想用例 |

| 中央处理器 | 通用计算 | 灵活,擅长连续任务 | 边缘网关、控制逻辑、轻量级 AI 工作负载 |

| 图形处理器 | 大规模模型训练 | 卓越的并行处理,高吞吐量 | 深度学习训练、图形渲染、模拟 |

| TPU | 使用 TensorFlow 进行训练和推理 | 专为矩阵数学而构建,并针对 Google AI 进行了优化 | Google Cloud 中的深度学习工作负载 |

| 神经网络处理器 | 边缘实时 AI 推理 | 节能、低延迟的 AI 加速 | 智能相机、工业自动化、物联网、移动设备 |

更多见解

- • 架构重点:CPU 处理顺序操作,GPU 擅长并行训练,TPU 专为云端的 TensorFlow 量身定制,NPU 专门用于边缘的实时推理。

- • 功率效率:NPU 通常比 GPU 或 TPU 消耗的功率少得多,因此更适合移动和嵌入式系统。

- • 延迟:NPU 可以提供近乎即时的结果,这对于自动驾驶或工业监控至关重要。

- •部署灵活性:NPU 通常集成到 SoC 中,从而实现智能手机和边缘设备的紧凑设计。

您需要 NPU 吗?

CPU、GPU 和 NPU 之间的选择取决于工作负载的性质。对于训练大规模 AI 模型,GPU 和 TPU 仍然是最佳选择。对于包含较轻量级 AI 任务的多功能计算,CPU 仍然具有价值。然而,对于高效且反复地运行预训练模型,NPU 是无与伦比的。它们提供了最节能且经济的方式来处理推理工作负载,尤其是在大规模和边缘环境中。

对于功耗并非主要考虑因素的小型消费项目,GPU 可能就足够了。但在需要在多台设备上持续、实时地提供 AI 性能的工业和企业应用中,NPU 则具有明显的优势。

InnoAioT 强固型无风扇计算机支持 Hailo-8™ 模块

InnoAioT坚固耐用型无风扇计算机提供丰富的功能和选项,搭载英特尔® 第 12 代酷睿处理器、工业级材料和无风扇设计,并支持宽温。集成 Hailo-8 M.2 AI 性能模块,有助于实现性能、能效和成本的理想平衡,是边缘 AI 的理想之选。

Hailo-8™ 处理器是一款紧凑型 AI 加速器,每秒可提供高达 26 万亿次运算,典型功耗低于 2.5 瓦。Hailo 的这款处理器提供三种 M.2 模块——B-Key、E-Key 和 M-Key,可实现即插即用。InnoAioT 坚固耐用型无风扇计算机支持 Hailo-8™ AI 加速器模块,用户可通过 M.2 M-Key 2280 插槽轻松集成。

未来之路

随着人工智能持续从以云为中心的处理向边缘部署迁移,NPU 势必将成为未来计算平台不可或缺的一部分。它们在功耗和性能之间实现了完美平衡,使智能能够直接嵌入到设备中,而无需承担持续云交互带来的成本和延迟。

从智能手机到医疗计算机,从工厂自动化到智慧城市,NPU 正悄然成为实现本地化人工智能的引擎。在英特尔和 Hailo 等公司引领创新的背景下,NPU 的普及预示着更广泛的行业趋势:高效、可扩展的人工智能将越来越多地在设备上运行,让我们更接近真正智能的边缘生态系统。